Would you like to get notifications from Christian?

Algoritmen, AI en Big Data bieden allemaal nieuwe manieren om betere, snellere en datagestuurde beslissingen te nemen. Maar het komt met een zware prijs! Wij hebben de controle verloren en zijn niet meer in staat te begrijpen hoe deze systemen beslissingen nemen die ons leven beïnvloeden. Nog verontrustender is dat wij zelfgenoegzaam zijn geworden en ons comfortabel voelen met dit gebrek aan inzicht. Wij hebben ons agentschap opgegeven om deze systemen verantwoordelijk te houden. Maar wat als er een manier was voor AI om zijn besluitvormingsproces uit te leggen? Zou dat je meer comfortabel maken met het vertrouwen in AI?

Het is geen geheim dat kunstmatige intelligentie met de dag geavanceerder wordt. Wat vroeger science fiction was, is nu werkelijkheid, dankzij algoritmen die enorme hoeveelheden gegevens kunnen verwerken. Deze grote macht brengt echter ook verantwoordelijkheid met zich mee: naarmate AI alomtegenwoordiger wordt, moeten wij ervoor zorgen dat de besluiten die daaruit voortvloeien transparant zijn en dat daarover verantwoording wordt afgelegd. Een team van onderzoekers van PRODI aan de Ruhr-Universität Bochum ontwikkelt een nieuwe aanpak om precies dat te doen.

Het team heeft gewerkt aan een manier om kunstmatige intelligentie meer verantwoordelijk te maken voor haar beslissingen. Momenteel neemt AI beslissingen op basis van algoritmen die voor ons mensen ondoorzichtig zijn. Dit gebrek aan transparantie kan leiden tot wantrouwen en een gevoel van machteloosheid. Het doel van het team is een nieuwe aanpak te ontwikkelen om het besluitvormingsproces van AI transparant te maken, zodat we het kunnen vertrouwen.

De aanpak die het team ontwikkelt, zou AI in staat stellen zijn beslissingen uit te leggen op een manier die voor mensen begrijpelijk is. Als je bijvoorbeeld een AI-gestuurde app gebruikt om een hotelkamer te boeken, kan de app uitleggen hoe hij op basis van jouw voorkeuren de kamer heeft gekozen die hij heeft gekozen. Dit zou u een beter inzicht geven in hoe AI werkt en u helpen om weloverwogen beslissingen te nemen over het gebruik van AI in de toekomst. Of wat dacht je van een AI algoritme dat dodelijke ziekten diagnosticeert? Als het algoritme zijn beslissing aan een arts en patiënt kan uitleggen, zou dat helpen vertrouwen te wekken in zijn vermogen om accurate diagnoses te stellen.

Het team werkt nog aan de aanpak en heeft deze nog niet in reële toepassingen toegepast. Zij hebben echter goede hoop dat hun werk zal leiden tot een nieuw tijdperk van transparantie en verantwoordingsplicht voor AI. In een wereld waar AI steeds meer gemeengoed wordt, is dit een cruciale stap om ervoor te zorgen dat we de beslissingen die het neemt, kunnen vertrouwen.

Denkt u dat deze nieuwe aanpak gunstig zou zijn? Zou u zich meer op uw gemak voelen bij het gebruik van AI als het zijn besluitvormingsproces kon uitleggen? Laat ons weten wat je denkt in de commentaren hieronder!

Auteur: Christian Kromme

Voor het eerst verschenen op: Disruptive Inspiration Daily

Christian is een futurist en trendwatcher die spreekt over de impact van exponentiële technologieën zoals AI op organisaties, mensen en talenten. Christian stemt zijn presentaties af op de specifieke branches en behoeften van uw publiek.

Formaat:

Stelt u zich eens voor dat u met slechts 10-15 collega-managers op een toplocatie zit en dat u duidelijkheid krijgt over de impact van AI op uw branche, terwijl u geniet van een voortreffelijke lunch of diner ervaring. Dit zijn niet zomaar sessies, het zijn transformatieve momenten die de toekomst van uw organisatie vorm zullen geven.

Robotica en AI zullen ons in staat stellen te reizen in duurzame, autonome voertuigen die zelfs door de meest complexe omgevingen kunnen navigeren. En dankzij mobility-as-a-service providers zullen we ons nooit meer zorgen hoeven te maken over parkeer-, onderhouds- of brandstofkosten.

In de toekomst zullen 3D-printing en generatief design het mogelijk maken producten op een meer gedecentraliseerde manier te ontwerpen, en zal de productie dichter bij de klant en volledig on-demand plaatsvinden. 3D-printtechnologie zal ook meer maatwerk en personalisering van producten mogelijk maken.

De landbouwsector is rijp voor disruptie. Robotica, AI en IoT zijn allemaal technologieën die het potentieel hebben om de manier waarop we voedsel verbouwen radicaal te veranderen. In combinatie met verticale landbouw zouden deze technologieën de efficiëntie en kwaliteit van landbouwproducten kunnen verhogen.

Een op de mens gerichte samenleving is een samenleving waarin de mens op de eerste plaats komt en waarin technologie wordt gebruikt om mensen te verenigen en mondig te maken. Het is een samenleving die biologisch leven en waardigheid boven alles stelt. Het is een samenleving die het belang van menselijke relaties erkent en ernaar streeft deze te versterken.

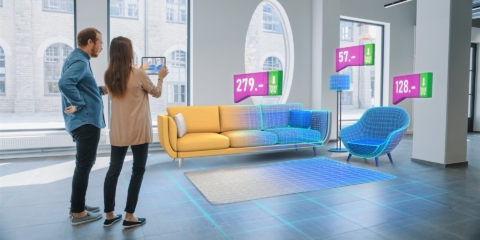

Het is moeilijk te geloven, maar de manier waarop we producten ervaren en kopen is aan het veranderen. Met de komst van opkomende technologieën zoals kunstmatige intelligentie (Ai) en augmented reality (AR) en 3D-printing, smelten e-commerce en traditionele retail samen tot één ervaring.

Onderwerp:

De boekhoud- en financiële sector staat aan de vooravond van een enorme disruptie. Met de opkomst van kunstmatige intelligentie, intelligente blockchaincontracten en DEFI staan traditionele boekhoud- en financiële processen op het punt vervangen te worden door efficiëntere en veiligere methoden.

Onderwerp:

Het is moeilijk te geloven, maar de manier waarop we producten ervaren en kopen is aan het veranderen. Met de komst van opkomende technologieën zoals kunstmatige intelligentie (Ai) en augmented reality (AR) en 3D-printing, smelten e-commerce en traditionele retail samen tot één ervaring.

Onderwerp:

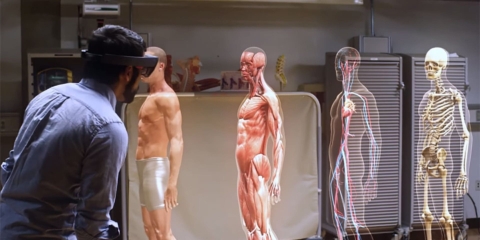

De toekomst van de gezondheidszorg is hier. Nieuwe technologieën zoals AI, IoT, big data en slimme sensoren maken het mogelijk om de CEO van je eigen gezondheid te worden. Stel je voor dat je telefoon naar je stem kan luisteren en AI-algoritmes kleine nuances in de toon van je stem kunnen detecteren die duiden op specifieke ziekten.